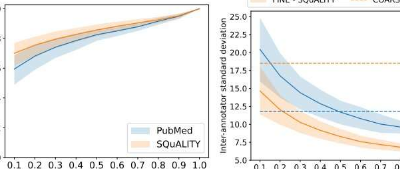

ChatGPT等人工智能文本生成器的公开发布,在那些宣称该技术是通信领域巨大飞跃的人和那些预言该技术将产生可怕影响的人中引起了巨大轰动。然而,人工智能生成的文本存在着众所周知的错误,而人类评估仍然是确保准确性的黄金标准,尤其是在生成复杂文本的长格式摘要等应用程序时。然而,人类对长篇摘要的评估还没有公认的标准,这意味着即使是黄金标准也值得怀疑。

为了纠正这一缺陷,由麻省大学阿默斯特分校曼宁信息与计算机科学学院研究生KalpeshKrishna领导的计算机科学家团队刚刚发布了一套名为LongEval的指南。该指南在计算语言学协会欧洲分会上发布,并因此被授予杰出论文奖。

克里希纳在艾伦人工智能研究所实习期间开始了这项研究,他说:“目前没有可靠的方法来评估没有人类的长格式生成文本,即使是当前的人类评估协议也是昂贵、耗时且高度可变的。”。“合适的人类评估框架对于构建更准确的长文本生成算法至关重要。”

Krishna和他的团队(包括麻省大学阿默斯特分校计算机科学助理教授MohitIyyer)梳理了162篇长篇摘要论文,以了解人类评估的工作原理,结果发现73%的论文没有表现出色人类对长篇摘要的评估根本不存在。其余论文使用了截然不同的评估实践。

“缺乏标准是有问题的,因为它妨碍了可重复性,并且不允许在不同系统之间进行有意义的比较,”艾耶尔说。

为了进一步实现对人工智能生成的摘要进行人类评估的高效、可重复和标准化协议的目标,Krishna和他的合著者制定了一份包含三项综合建议的清单,其中涵盖了评估者应该如何阅读以及阅读哪些内容,以判断摘要的可靠性。概括。

“通过LongEval,我对能够与人类一起准确、快速地评估长文本生成算法的前景感到非常兴奋,”Krishna说。“我们使LongEval变得非常易于使用,并将其作为Python库发布。我很高兴看到研究社区如何在此基础上构建并在他们的研究中使用LongEval。”