深度神经网络(DNN)已被证明是分析大量数据的非常有前途的工具,可以加速各个科学领域的研究。例如,在过去几年中,一些计算机科学家基于这些网络训练了模型来分析化学数据并识别适合各种应用的有前景的化学物质。

麻省理工学院(MIT)的研究人员最近开展了一项研究,调查基于DNN的大型模型的神经缩放行为,这些模型经过训练可以生成有利的化学成分并学习原子间势。他们发表在《自然机器智能》上的论文表明,随着这些模型的规模和训练数据池的增加,这些模型的性能可以多快地提高。

“Kaplan等人的论文‘神经语言模型的缩放定律’是我们研究的主要灵感,”进行这项研究的研究人员之一NathanFrey告诉TechXplore。“该论文表明,增加神经网络的规模及其训练的数据量可以带来模型训练的可预测的改进。我们希望了解‘神经缩放’如何应用于化学数据训练的模型,以及药物发现等应用”。

Frey和他的同事早在2021年就开始从事这个研究项目,也就是在著名的基于人工智能的平台ChatGPT和Dall-E2发布之前。当时,DNN的未来升级被认为与某些领域特别相关,并且探索其在物理或生命科学中的扩展的研究很少。

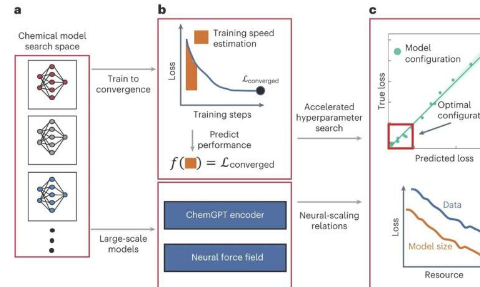

研究人员的研究探索了两种不同类型的化学数据分析模型的神经扩展:大语言模型(LLM)和基于图神经网络(GNN)的模型。这两种不同类型的模型可分别用于生成化学成分并学习化学物质中不同原子之间的电势。

“我们研究了两种截然不同的模型:我们构建的一种自回归GPT风格的语言模型,称为‘ChemGPT’,以及一系列GNN,”Frey解释道。“ChemGPT的训练方式与ChatGPT相同,但在我们的例子中,ChemGPT试图预测代表分子的字符串中的下一个标记。GNN被训练来预测分子的能量和力。”

为了探索ChemGPT模型和GNN的可扩展性,Frey和他的同事探索了模型大小以及用于在各种相关指标上训练模型的数据集大小的影响。这使他们能够得出这些模型随着模型变大并输入更多数据而改进的速度。

“我们确实发现了化学模型的‘神经缩放行为’,让人想起法学硕士和各种应用的视觉模型中看到的缩放行为,”弗雷说。

“我们还表明,我们还没有接近扩展化学模型的任何基本极限,因此仍然有很大的空间可以通过更多的计算和更大的数据集进一步研究,通过称为“等方差”的属性将物理学纳入GNN具有以下优点:对提高扩展效率产生了巨大的影响,这是一个令人兴奋的结果,因为实际上很难找到改变扩展行为的算法。”

总体而言,该研究小组收集的研究结果为两种类型的人工智能模型进行化学研究的潜力提供了新的线索,显示了随着规模的扩大,它们的性能可以在多大程度上提高。这项工作很快就会为更多研究提供信息,探索这些模型以及其他基于DNN的特定科学应用技术的前景和改进空间。

“自从我们的工作首次出现以来,已经有令人兴奋的后续工作探索化学模型缩放的能力和局限性,”弗雷补充道。“最近,我还一直致力于蛋白质设计的生成模型,并思考缩放如何影响生物数据模型。”